Extensão de navegador pode capturar e vender conversas usando inteligência artificial

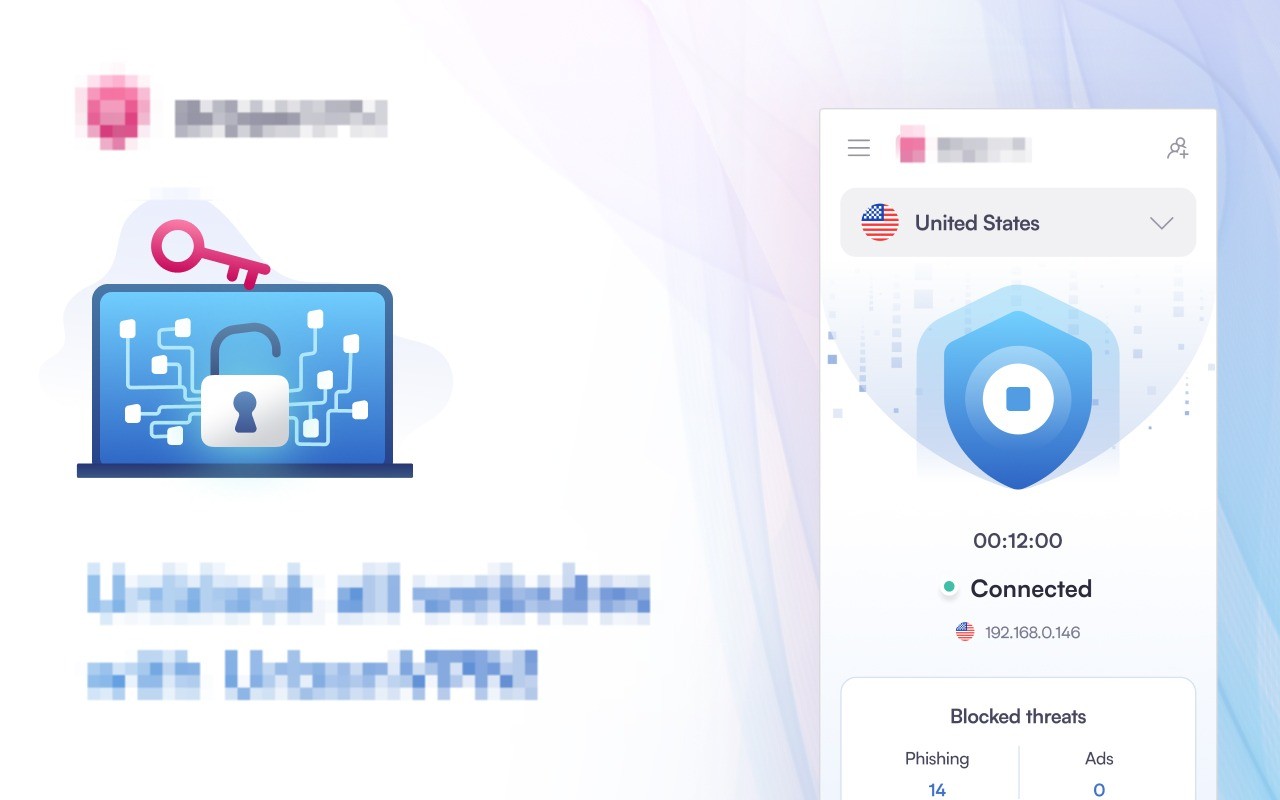

Plataformas como ChatGPT, Gemini e outras de inteligência artificial se tornaram confidentes, médicos e psicólogos para muitas pessoas. São espaços onde os usuários compartilham dados pessoais sobre suas vidas, desde questões emocionais até informações financeiras e de saúde. Mas diversos especialistas alertaram recentemente sobre os riscos ocultos de compartilhar informações pessoais com essas plataformas e descobriram como algumas empresas estão tornando esses dados públicos. Leia mais: Google está na mira de associação espanhola de consumidores por suposta invasão de privacidade Entenda: brinquedos com IA revelam novos riscos digitais para crianças Há alguns dias, uma investigação da KOI (empresa de segurança que avalia e aplica políticas de software para organizações) causou alvoroço, alegando que uma extensão de navegador que muitas pessoas instalam em seus dispositivos captura conversas com inteligências artificiais e, em seguida, vende os dados para gerar lucro. O Urban VPN Proxy é uma extensão gratuita para o Chrome com mais de 6 milhões de usuários. A ferramenta promete ocultar os endereços IP dos usuários, permitindo uma navegação mais anônima e contornando restrições geográficas, concedendo, assim, acesso a sites ou serviços que podem ser restritos em determinadas regiões. No entanto, suas promessas de privacidade e segurança parecem ser falsas, visto que foi descoberto que ela está lendo, extraindo e vendendo conversas que os usuários têm com plataformas de IA. Especificamente, a extensão intercepta e captura conversas de dez plataformas, incluindo ChatGPT, Claude, Gemini, Microsoft Copilot, Perplexity, Deep Research, Grok (xAI) e Meta IA. A coleta de dados está ativada por padrão e não há opções visíveis para o usuário desativar esse recurso. Na verdade, independentemente de a VPN estar conectada ou não, a coleta de dados ocorre continuamente. Que dados são extraídos? Todas as mensagens enviadas à IA, todas as respostas fornecidas, identificadores e registros de data e hora das conversas, metadados da sessão e a plataforma e o modelo de IA específicos utilizados. Vale ressaltar que essa coleta de dados nem sempre esteve presente; a atualização só entrou em vigor em julho deste ano. Como as extensões do Chrome e do Edge são atualizadas automaticamente, os usuários que tinham o Urban VPN instalado em suas plataformas acordaram um dia e encontraram "um novo código compilando silenciosamente suas conversas com a IA", de acordo com o relatório. "Qualquer pessoa que tenha usado o ChatGPT, Claude, Gemini ou outras plataformas visadas enquanto o Urban VPN estava instalado após 9 de julho de 2025 deve presumir que essas conversas agora estão nos servidores do Urban VPN e foram compartilhadas com terceiros. Questões médicas, informações financeiras, código proprietário, dilemas pessoais — tudo vendido para fins de análise de marketing." “É 100% provável, em termos técnicos e operacionais: é exatamente assim que as extensões de navegador com essas permissões funcionam”, explica Joan Cwaik, autor, comunicador de tecnologia e professor da Universidade de San Andrés, acrescentando: “São extensões que já possuíam as permissões necessárias para fazer esse tipo de coisa: ler o conteúdo da página, injetar scripts, interceptar tráfego — nada ilegal do ponto de vista técnico, nada de hackeado.” Mas a investigação não termina aí: de acordo com o estudo, esses dados coletados são vendidos a anunciantes. “A Urban VPN é operada pela Urban Cyber Security Inc., que é afiliada à BiScience (BI Science (2009) Ltd.), uma empresa de corretagem de dados”, detalha o relatório, explicando que essa empresa já foi alvo de investigação por pesquisadores, como John Tuckner, da Secure Annex, que anteriormente documentou as práticas da BiScience e indicou que ela coletava dados de usuários e os vendia. “A BiScience passou de coletar histórico de navegação para conversas completas de IA, uma categoria de dados significativamente mais sensível”, acrescenta o relatório, explicando como seria o fluxo de dados que eles realizam agora: “Compartilhamos dados de navegação na web com nossa empresa afiliada, a BiScience, que usa esses dados brutos e gera informações que são usadas comercialmente e compartilhadas com parceiros de negócios.” Leia também: Spotify diz que 'hackers' invadiram seu catálogo; grupo diz ter copiado 86 milhões de músicas Entenda: por que os chatbots de inteligência artificial usam a palavra 'eu'? A investigação observa que a Urban VPN esclarece isso em sua solicitação de consentimento: menciona que processa comunicações do ChatAI, páginas visitadas e sinais de segurança para fornecer essas proteções. Acrescenta ainda que "também divulgamos indicações de IA para fins de análise de marketing". No entanto, o problema é que a Chrome Web Store (o local onde os usuários escolhem se instalam ou não aplicativos) afirma algo diferente: "Este desenvolvedor declara que seus dados não serão vendidos a terceiros, exceto nos casos de uso aprovados". Mais vazamentos de dados Essa extensão, porém, não é a única que revela os dados pessoais inseridos na inteligência artificial. Poucas pessoas sabem que o que é compartilhado com essas ferramentas de IA é usado para treinar ainda mais o modelo. Em outras palavras, conversas com o ChatGPT, Gemini e outras versões gratuitas ou pessoais de IA podem ser usadas para aprimorar o sistema, porque isso vem como padrão, a menos que o usuário desative manualmente nas configurações. No entanto, nem todos os modelos funcionam da mesma maneira, já que as versões corporativas ou de trabalho não utilizam dados para treinamento e existem acordos formais que protegem as informações. Nas palavras de Juan Pablo Cosentino, professor associado e diretor acadêmico da área de Operações e Tecnologia da IAE Business School, a escola de negócios da Universidade Austral. “Há uma regra simples que se aplica nesta área: se é gratuito, saiba que nada é realmente gratuito; portanto, considere que o modelo foi treinado com seus dados.” Sergio Pernice, diretor de Engenharia de Inteligência Artificial da UCEMA, explica que os provedores esclarecem em seus termos e condições se utilizam ou não os dados do usuário para treinar modelos. “Nas seções ‘Termos de Uso’, ‘Conteúdo’ e ‘Nosso Uso do Conteúdo’ do ChatGPT Personal (Gratuito/Plus/Pro), eles especificam que podem usar seu conteúdo ‘para oferecer, manter, desenvolver e aprimorar nossos Serviços’ e que você pode optar por não participar”, detalha Pernice, explicando que, embora os modelos não "revelem seus segredos", eles podem "memorizar" fragmentos de texto raros ou únicos. "Se outro usuário fizer uma pergunta muito semelhante, há uma pequena chance de que algo parecido com o que você escreveu apareça", acrescenta. Qual é o perigo? Se a IA se disseminar globalmente e for usada em ambientes de trabalho, existe um risco significativo de vazamento de informações confidenciais relacionadas ao trabalho. E, segundo especialistas, isso já está acontecendo. “A adoção em massa da IA generativa desencadeou um fenômeno silencioso: funcionários e gerentes estão colando textos sensíveis (contratos, folha de pagamento, código proprietário, dados confidenciais da empresa, estratégias de marketing) em chats públicos ou contas gratuitas. A produtividade aumenta, mas também o risco de violações de dados e descumprimento de normas”, explica Matias Hilaire, CEO da The App Master, uma empresa argentina que cria soluções tecnológicas para startups e pequenas e médias empresas. E fornece dados que mostram como a IA entrou nas empresas "pela porta dos fundos": um relatório da Microsoft (de outubro de 2025) constatou que 71% dos trabalhadores usam ferramentas de IA não aprovadas por suas empresas. Se somarmos a isso outros dados, como um estudo publicado pela TechRepublic, segundo o qual 77% dos funcionários compartilham dados sensíveis com o ChatGPT ou outros sistemas de inteligência artificial, o resultado se torna ainda mais alarmante. No entanto, embora apenas as versões gratuitas utilizem os dados, Hilaire esclarece que menos de 10% dos usuários de plataformas como o ChatGPT possuem uma conta paga. “É crucial que as organizações definam políticas claras sobre o uso de IA e garantam que elas sejam seguidas. As plataformas utilizadas devem ser validadas pelas equipes”, acrescenta Hilaire.