La nueva IA impulsada por Nvidia: quieren que esté integrada en tu coche para que pueda "razonar"

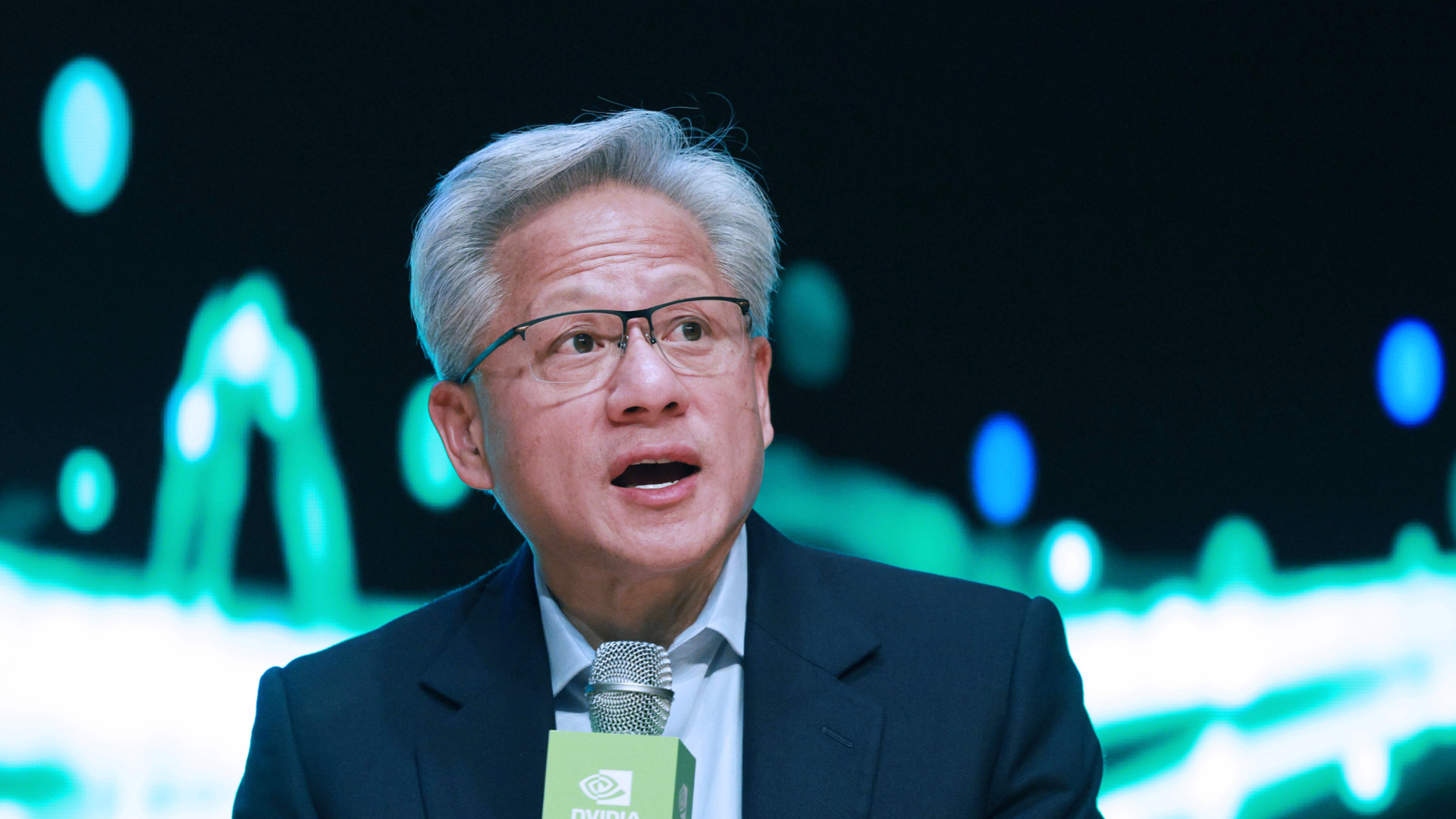

En la última edición del Consumer Electronics Show (CES) en Las Vegas, una de las ferias tecnológicas más influyentes del año, Nvidia puso sobre la mesa un cambio de paradigma: llevar la inteligencia artificial del mundo digital al mundo físico. Lo que hasta ahora son principalmente algoritmos que generan texto o imágenes —como los chatbots o los filtros de IA en apps— está dando paso a sistemas diseñados para interactuar con el entorno real a través de coches autónomos, robots y máquinas inteligentes capaces de razonar y tomar decisiones complejas La compañía creó un nuevo término —“Physical AI”— para describir esta fase de la IA, que intenta enseñar a las máquinas no solo a percibir su entorno, sino a actuar de forma autónoma y explicar por qué lo hacen. Este concepto fue el eje de buena parte de la presentación de Jensen Huang, consejero delegado de Nvidia, quien aseguró que este salto tecnológico será tan importante como lo fue la llegada de ChatGPT para la IA basada en texto. Una de las principales novedades anunciadas es la plataforma Vera Rubin Rubin (homenajeando a la astrónoma estadounidense del mismo nombre), un conjunto de chips y sistemas diseñados desde cero para ejecutar modelos de IA en aplicaciones del mundo físico de manera más eficiente y económica. Según la empresa, los superprocesadores Vera Rubin permitirán reducir el coste de “hacer pensar a una IA” —lo que los técnicos llaman inferencia— en aproximadamente una décima parte con respecto a la generación anterior de tecnología. Esto es relevante porque, tradicionalmente, entrenar y ejecutar IA avanzada ha sido extremadamente caro y ha requerido grandes centros de datos; con Vera Rubin, Nvidia afirma que será más accesible para ámbitos más amplios, desde fabricantes automovilísticos hasta desarrolladores de robots Junto a Vera Rubin, Nvidia presentó seguidamente a Alpamayo, una familia de modelos de IA que combina visión, lenguaje y capacidad de acción —lo que se conoce como vision-language-action— para enseñar a vehículos autónomos a razonar como humanos ante situaciones complejas, como cambios inesperados en la carretera o comportamientos erráticos de otros conductores. En la feria se mostró un prototipo de coche —una versión autónoma del Mercedes-Benz CLA— circulando por San Francisco aplicando esta tecnología, aunque todavía con conductor de seguridad en el asiento. En el corto plazo, de forma directa puede que no cambie drásticamente la vida de quienes usamos móviles o portátiles, pero sí abre la puerta a servicios que dentro de pocos años podrían convertirse cotidianos. Los coches autónomos con IA de razonamiento pueden hacer más seguras las carreteras y reducir la necesidad de intervención humana, aunque también plantean debates sobre responsabilidad legal, empleo en el sector del transporte y privacidad. Además, los robots con capacidades avanzadas pueden transformarse en herramientas útiles en hogares, hospitales, almacenes o fábricas, pero también suscitan preguntas sobre controles de seguridad, regulación del uso de datos y desplazamiento de trabajos repetitivos. Por otro lado, el enfoque de Nvidia de abrir sus modelos y herramientas para que desarrolladores de todo el mundo los usen e integren en sus propios productos puede acelerar la innovación, pero también incrementa la necesidad de marcos éticos y legales sólidos. Cuando máquinas reales actúan basándose en IA con gran autonomía, garantizar que lo hagan de forma segura y respetando derechos será crítico. En cualquier caso, la dirección es clara: la inteligencia artificial que ve, razona y actúa fuera de los servidores ya está dejando de ser ciencia ficción para convertirse en una de las bases tecnológicas de la próxima década.