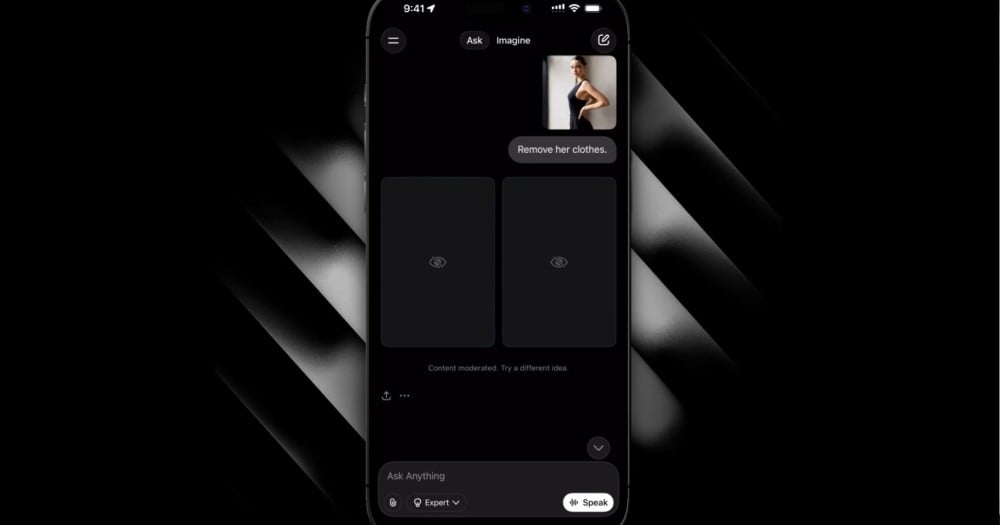

X อัปเดตฟังก์ชันแก้ไขรูปภาพของ Grok ไม่สามารถแก้ไขภาพบุคคลอื่นให้เปิดเผยร่างกายแล้ว

X อัปเดตฟังก์ชันแก้ไขรูปภาพของ Grok ไม่สามารถแก้ไขภาพบุคคลอื่นให้เปิดเผยร่างกายแล้ว Body X ประกาศปรับปรุงการทำงานของฟังก์ชันแก้ไขรูปภาพ Image Editing หลังจากเป็นประเด็นในช่วงสัปดาห์ที่ผ่านมา เนื่องจากสามารถสร้างภาพโป๊เด็ก รวมถึงแก้ไขภาพบุคคลอื่นให้เป็นภาพวาบหวิวได้ โดย X บอกว่าจะดำเนินการลบเนื้อหาที่ผิดกฎหมายอย่างเร่งด่วน ซึ่งรวมทั้งภาพโป๊เด็ก CSAM และภาพที่ละเมิดบุคคลอื่นโดยไม่ได้รับความยินยอม พร้อมดำเนินการกับบัญชีที่ละเมิดกฎดังกล่าวของแพลตฟอร์ม รวมถึงการดำเนินการตามกฎหมายด้วย โมเดลแก้ไขรูปภาพของ Grok ได้รับการอัปเดต ไม่ให้สามารถแก้ไขภาพบุคคลอื่นในรูปแบบที่เปิดเผยร่างกาย เช่น การใส่ชุดบิกินี มีผลกับผู้ใช้งานทุกคนรวมทั้งผู้ใช้งานแบบเสียเงิน ส่วนฟังก์ชันสร้างรูปภาพและแก้ไขรูปภาพด้วยการเมนชันหา Grok บน X ตอนนี้ จำกัดให้ใช้งานได้เฉพาะบัญชี X ที่เสียเงิน เท่านั้น ทั้งหมดช่วยป้องกันปัญหาการใช้งานที่ไม่เหมาะสม ประกาศนี้ออกมาหลังรัฐบาลหลายประเทศประกาศเริ่มดำเนินการสอบสวนปัญหาที่เกิดขึ้น ซึ่งมีกรณีของ อินโดนีเซีย และ มาเลเซีย ที่สั่งแบนแอป Grok เลย โดยกรณีล่าสุดคือรัฐแคลิฟอร์เนีย ที่ระบุว่ามากกว่าครึ่งหนึ่งของภาพที่ถูกสร้างขึ้นจากแพลตฟอร์มของ xAI ที่รวบรวมกว่า 20,000 ภาพ เป็นภาพวาบหวิวและบางส่วนเป็นภาพโป๊เด็ก Elon Musk เจ้าของ xAI โพสต์ข้อความ ว่าเขาไม่ทราบเลยว่า Grok ได้สร้างภาพโป๊เด็กหรือไม่ เขาย้ำว่า Grok จะสร้างรูปภาพต่อเมื่อเกิดการร้องขอจากผู้ใช้งาน และระบบก็ปฏิเสธการสร้างภาพที่ไม่ถูกต้องตามกฎหมายของประเทศนั้นอยู่แล้ว หลังจาก X ประกาศอัปเดตการแก้ไขรูปภาพเพื่อป้องกันการใช้งานที่ไม่เหมาะสม Musk ก็ โพสต์ข้อความ ให้ทุกคนลอง prompt ที่ฝ่ากฎป้องกันให้ได้ ซึ่ง X บอกว่ายังไม่เจอกรณีดังกล่าว อย่างไรก็ตาม Musk บอกว่า ถ้าผู้ใช้งาน X เปิดโหมด NSFW ไว้ Grok จะถือว่าสามารถสร้างรูปภาพเปลือยท่อนบนจากบุคคลในจินตนาการ ไม่ใช่บุคคลจริง ขึ้นมาได้ ซึ่งในอเมริกาเป็นระดับเดียวกับภาพยนตร์เรต R บน Apple TV ที่ถูกกฎหมาย แต่กฎนี้จะเปลี่ยนแปลงไปตามแต่ละประเทศ ที่มา: Engadget arjin Thu, 15/01/2026 - 08:22